Le Time to Task Completion (TTC), aussi appelé Task Completion Time (TCT) est une mesure du temps nécessaire à un internaute depuis la saisie de sa requête jusqu’à la finalisation de sa recherche.

Le TTC est un indicateur clé pour mesurer la satisfaction de l’intention de recherche et optimiser votre SEO. C’est une mesure qui ne peut qu’être approximée, mais qui permet de driver la stratégie SEO. En partant du principe que l’objectif de Google est de permettre à ses utilisateurs d’obtenir ce qu’ils cherchent le plus vite vite possible, penser TTC permet de penser comme Google et d’augmenter la probabilité d’être en première place.

TL;DR : vous pouvez jumper directement aux recommandations et passer la partie explicatives

Le TCT a déjà fait l’objet d’une publication que je ne peux que vous recommander de lire si vous avez le temps. Je mets en annexe une synthèse.

Concrètement, le Time to Task Completion inclut :

- Le temps passé sur la page de résultats de recherche (SERP) : temps de réflexion, comparaison entre les différents liens.

- Le temps de chargement de la page : la vitesse à laquelle la page de destination s’affiche.

- Le temps de navigation/lecture sur la page : le laps de temps nécessaire pour trouver la réponse exacte à la requête

Cet article vous propose de plonger dans les détails de cette notion, de comprendre son impact sur le SEO, et d’explorer des concepts connexes comme le dwell time et le « navboost ».

1. Qu’est-ce que le Time to Task Completion (TTC) ?

Le Time to Task Completion (TTC) est un indicateur comportemental qui mesure la durée qu’il faut à un internaute pour mener à bien sa recherche et trouver l’information spécifique qu’il souhaite.

Contrairement à un simple temps de session ou un dwell time limité à la page, le TTC offre une vision plus holistique de l’expérience utilisateur, puisqu’il prend en compte :

- La phase de recherche en SERP :

- L’utilisateur tape sa requête, étudie les différents titres et extraits (snippets) proposés par le moteur de recherche.

- Il compare les options pour choisir la page qui lui semble la plus pertinente.

- Le temps de chargement de la page :

- L’utilisateur doit attendre que la page s’affiche complètement.

- Un long temps de chargement peut augmenter le TTC et potentiellement provoquer un abandon.

- Le temps de navigation/lecture :

- L’utilisateur parcourt le contenu de la page à la recherche de la réponse souhaitée.

- Si le visiteur trouve rapidement ce dont il a besoin, le TTC sera faible.

- Si l’utilisateur ne trouve pas son bonheur, il pourrait rebondir vers la SERP pour tenter d’obtenir une réponse dans un autre résultat.

En somme, le TTC se veut un indicateur très représentatif de la satisfaction de l’intention de recherche : plus il est faible, plus on peut estimer que l’utilisateur a obtenu rapidement ce qu’il était venu chercher.

2. Quelle est la différence entre le Time to Task Completion et le dwell time ?

Le dwell time est un indicateur qui mesure le temps passé par un internaute sur une page avant de revenir sur les résultats de recherche. Autrement dit, si l’on constate qu’une personne clique sur un résultat, consulte le contenu, puis revient sur la SERP après, disons, 2 minutes, on dit que le dwell time est de 2 minutes.

- Dwell time se limite à la session sur la page de destination et la comparaison avec un éventuel retour en arrière.

- TTC s’étend lui du moment où l’utilisateur consulte la SERP jusqu’au moment où il finit réellement sa tâche, incluant le temps de chargement, l’orientation dans la SERP, la navigation sur plusieurs sites, les requêtes nécessaires pour affiner la recherche etc.

Ainsi, le dwell time peut être considéré comme un composant du Time to Task Completion, mais il ne le recouvre pas entièrement.

3. Pourquoi le Time to Task Completion est-il important en SEO ?

3.1. L’expérience utilisateur au cœur de l’algorithme

Les moteurs de recherche, Google en tête, visent à satisfaire au mieux l’intention de recherche de l’utilisateur. Ils ont tout intérêt à :

- Proposer des résultats pertinents et de qualité

- Assurer une expérience utilisateur fluide

- Permettre à leurs utilisateurs d’obtenir ce qu’ils cherchent le plus vite possible

Le Time to Task Completion étant un indicateur de satisfaction (puisque l’utilisateur parvient effectivement à finaliser sa recherche), il peut être lié à la performance SEO d’un site :

- Si un site propose des réponses claires et rapides, l’utilisateur est susceptible de terminer sa tâche en un temps record, ce qui peut être perçu positivement.

- À l’inverse, si la page est confuse, met longtemps à se charger ou ne répond pas au besoin, l’internaute reviendra vite sur la SERP, augmentant le TTC et laissant penser au moteur de recherche que ce résultat n’est pas le plus pertinent.

3.2. Impact sur le comportement des utilisateurs (pogo sticking, bounce, etc.)

Le pogo sticking décrit le phénomène où un internaute clique sur un résultat, puis revient immédiatement (ou très rapidement) à la page de résultats pour cliquer sur un autre lien. C’est un mauvais signal puisqu’il indique que le résultat ne correspondait pas à ses attentes.

3.3. Relation avec le “navboost”

On parle parfois de “navboost” pour désigner l’effet positif d’un engagement utilisateur élevé et d’une navigation rapide vers les sites jugés les plus pertinents. En clair :

- Si le moteur de recherche détecte que les utilisateurs se dirigent massivement et rapidement vers une page et y trouvent satisfaction (peu de retours vers la SERP, bon dwell time, TTC réduit), il peut accorder un coup de pouce au positionnement. Le coup de boost sur la page peut-être très rapide. Un bon TTC peut également avoir un impact positif sur l’ensemble du site.

- Ainsi, optimiser son TTC participe indirectement à la capacité d’un site à être mieux classé et à bénéficier d’un effet « boost » dans les SERP, car l’intention est très vite comblée.

Pour en savoir plus sur le Navboost, RDV sur sur cet article du JournalDuNet qui interview Olivier de Segonzac sur ce sujet.

4. Comment mesurer et optimiser le Time to Task Completion ?

4.1. Mesurer le TTC

Mesurer le TTC de manière directe n’est pas toujours évident, car cela demande une analyse précise des données :

- Le temps sur la SERP : impossible à mesurer, sauf si l’on espionne le navigateur (extension, etc) ou le trafic réseau par exemple.

- Le temps de chargement de la page : ce sont des données plus accessibles (via PageSpeed Insights, Google Lighthouse, etc.).

- Le temps de navigation/lecture : on peut utiliser des scripts de tracking (par exemple Google Analytics 4 ou des outils tiers) pour estimer le temps passé avant l’interaction clé (clic sur un bouton, scroll, téléchargement, etc.).

Il est souvent plus simple de déduire ou d’estimer le TTC à partir de plusieurs métriques utilisateur (taux de rebond, temps moyen sur la page, comportement en entonnoir).

Le focus doit être porté sur la mesure du temps nécessaire pour que l’internaute soit 100% satisfait en fonction de son objectif :

- Remplissage d’un formulaire de contact / génération de leads

- Début interraction chat, email etc

- Achat d’un produit (+ ajout du temps de livraison éventuel)

- Recherche d’information

4.2 Formulaire de contact / génération de leads

Optimisation du TTC

- Réduire le nombre de champs dans le formulaire.

- Offrir une auto-complétion ou pré-remplir certaines informations.

- Assurer un chargement rapide et une ergonomie fluide.

- Ajouter des messages de validation instantanée pour éviter les erreurs bloquantes.

Il s’agit ici de mesure le temps qui s’est écoulé jusqu’à la soumission d’un formulaire.

Mesurer le TTC avec GA4

- Configurer un événement personnalisé :

- Marquer l’événement

form_startlorsqu’un utilisateur commence à remplir le formulaire. - Marquer l’événement

form_submitlorsque le formulaire est validé.

- Marquer l’événement

- Créer un rapport dans GA4 :

- Utiliser l’exploration utilisateur pour mesurer le temps écoulé entre

form_startetform_submit. - Analyser les abandons en comparant les occurrences de

form_startetform_submit.

- Utiliser l’exploration utilisateur pour mesurer le temps écoulé entre

- Analyser le temps total sur la session :

- Observer la durée entre la première page visitée et

form_submitpour voir si la réponse a été obtenue rapidement.

- Observer la durée entre la première page visitée et

4.3 Prise de contact par d’autres canaux (chat, appel, email)

Ce cas inclut les contacts établis via un chatbot, un appel téléphonique ou un envoi d’email via un CTA du site.

Optimisation du TTC

- Rendre le CTA visible et accessible sur toutes les pages stratégiques.

- Utiliser un chatbot intelligent pour guider l’utilisateur vers la solution.

- Proposer des réponses automatiques aux questions fréquentes.

Mesurer le TTC avec GA4

- Configurer les événements personnalisés :

chat_startlorsque l’utilisateur ouvre un chat.chat_sendlorsqu’un message est envoyé.call_clicklorsqu’un utilisateur clique sur un numéro de téléphone.email_clicklorsqu’un utilisateur clique sur une adresse email.

- Analyser la durée avant l’interaction :

- Utiliser le rapport d’événements pour mesurer le temps écoulé entre l’arrivée sur la page et le premier contact.

- Comparer avec des parcours utilisateurs pour détecter les obstacles éventuels.

4.4 Achat d’un produit (+ temps de livraison éventuel)

Le TTC pour un achat inclut le temps entre l’entrée sur le site et la validation du paiement, ainsi que le délai de livraison perçu. En effet, l’objectif de l’internaute n’est atteint qu’au moment ou la livraison est effective.

Optimisation du TTC

- Simplifier le processus d’achat (checkout en une page, paiement express, options de connexion rapide).

- Réduire le temps de chargement des pages produit et de validation du panier.

- Offrir des délais de livraison clairs et compétitifs.

Mesurer le TTC avec GA4

- Configurer les événements e-commerce :

add_to_cartpour l’ajout au panier.begin_checkoutpour le début du processus de paiement.purchasepour la validation de l’achat.

- Analyser le temps total d’achat :

- Créer un rapport mesurant le temps entre

session_startetpurchase. - Identifier les points de friction via des taux d’abandon de panier.

- Créer un rapport mesurant le temps entre

- Prendre en compte le temps de livraison :

- Suivre les retours utilisateurs sur la rapidité de livraison.

- Intégrer un module de suivi de commande et mesurer l’engagement des utilisateurs après l’achat.

4.5. Autres axes pour mesurer et optimiser le TTC

Si votre site propose avant tout des informations (techniques ou autre), la mesure de la satisfaction est plus difficile.

Vous pouvez néanmoins envisager:

- Test humain “live”

- faire une recherche Google sur les top termes ciblés, et mesurer le temps nécessaire pour trouver l’information sur le site en première position versus votre page.

- GA4

- profondeur du scroll

- durée session

- taux de clic des liens internes

- NPS

- Net Promoteur Score: mesure sur la “recommandabilité” basée sur des feedback utilisateurs

- Analyse session

- Hotjar and co, pour regarder les sessions utilisateurs

4.6 Autre axes d’optimisation du TTC

Pour réduire le Time to Task Completion et améliorer l’expérience utilisateur (et par extension, le SEO), vous pouvez agir sur plusieurs leviers :

- Etre cliqué dans la SERP

- Optimisez la visibilité de vos pages dans les résultats de recherche Google en soignant les balises de titre () et de meta description, et en déployant des données structurées adaptées afin de bénéficier notamment de Rich Snippets (VideoObject, Recipies, JobPosting…)

- Satisfaire l’intention de recherche

- Proposer le meilleur contenu ou produit ou service possible.

- Si l’internaute cherche une réponse rapide, offrir un contenu concis et direct (ex. : short answer tout en haut + détails sous forme de chapitres).

- Mettre autant que possible en haut de page les informations les plus importantes pour prendre une décision.

- N’hésitez pas à jouer sur la taille des polices de caractère pour rendre les informations stratégiques bien évidentes.

- Optimiser le chargement des pages

- Google PageSpeed est une bonne source d’information. Surtout sur les metrics Core Web Vitals, qui tiennent compte de la perception utilisateur. Basez vous sur les données RUM pour que les metrics soient encore plus pertinent.

- Améliorer la pertinence et la clarté de votre contenu

- Répondre directement et clairement à l’intention de recherche (mise en avant d’un résumé, d’une FAQ, d’un extrait).

- Utiliser une structure hiérarchisée et claire (titres Hn, listes, paragraphes courts, etc.).

- Proposer un accès rapide à l’information clé (anchor links, sommaire, menu clair).

- Ajout de liens entre pages pour approfondir certains sujets avec des ancres explicites

- Travailler l’ergonomie et l’accessibilité de la page

- Concevoir des interfaces “user-friendly” et intuitives.

- Faciliter la navigation interne pour aider l’internaute à trouver rapidement ce qu’il cherche.

- Gérer l’affichage responsive pour une lecture aisée sur mobile.

- Vérifier les suggestions d’ergonomie proposée dans le rapport PageSpeed

- Analyser les parcours utilisateurs

- Via des cartes de chaleur (heatmaps) pour voir où les gens cliquent et scrollent.

- Exemple de metrics à surveiller: profondeur du scroll (dans GA4)

- Via des enregistrements de sessions pour détecter les blocages.

- Via des questionnaires ou tests utilisateurs pour recueillir des feedbacks qualitatifs.

- Via des cartes de chaleur (heatmaps) pour voir où les gens cliquent et scrollent.

5. Quels sont les bénéfices liés à l’optimisation du TTC ?

5.1. SEO: Amélioration du classement

Même si Google ne confirme pas officiellement l’utilisation du Time to Task Completion en tant que facteur de classement, la satisfaction de l’utilisateur doit être au cœur de la réussite d’une stratégie SEO pérenne:

- Un site qui répond plus vite et plus clairement aux intentions de recherche a plus de chances d’obtenir et de conserver de bonnes positions dans les SERP.

- De la même façon, des comportements utilisateurs positifs envoient de bons signaux aux moteurs de recherche:

- bon CTR dans les SERPs

- faible taux de rebond

- faibles retours sur la SERP

- conversions élevées

- …

5.2. Branding: Fidélisation de l’audience

En plus de l’impact potentiel sur le référencement, un TTC réduit contribue à la fidélisation :

- Un utilisateur qui trouve rapidement ses informations aura d’avantage tendance à revenir

- Sur le long terme, cela renforce la notoriété et la réputation de la marque.

7. Conclusion

Le Time to Task Completion (TTC), ou Task Completion Time, est un indicateur particulièrement intéressant pour appréhender la qualité de l’expérience utilisateur et, indirectement, l’efficacité de votre SEO. Plus qu’un simple temps passé sur la page, il intègre l’ensemble du processus de recherche, depuis la consultation de la SERP jusqu’à la finalisation du besoin informationnel.

En réduisant votre TTC, vous contribuez à :

- Améliorer l’expérience utilisateur (UX)

- Optimiser la pertinence de votre contenu vis-à-vis de l’intention de recherche

- Augmenter vos chances d’obtenir un navboost (un meilleur positionnement lié à des signaux utilisateurs positifs)

- Fidéliser votre audience en proposant une expérience de qualité

Pour y parvenir, portez une attention particulière à la vitesse de chargement, la structure de vos contenus, la navigation et l’ergonomie de vos pages. En vous focalisant sur la satisfaction du visiteur et en lui permettant de remplir sa tâche le plus rapidement et efficacement possible, vous développerez un atout concurrentiel de taille, tant pour l’expérience de vos visiteurs que pour votre visibilité dans les moteurs de recherche.

Annexe #1 – Synthèse de “

Evaluating Web Search Using Task Completion Time”

Source de la publication: https://research.google.com/archive/dmease-sigir09-full.pdf

Objectif de l’étude

- Évaluer la qualité d’un algorithme de recherche en mesurant le temps total nécessaire pour accomplir une tâche.

- Vérifier si un temps de recherche plus court est corrélé avec une meilleure satisfaction utilisateur.

Méthodologie

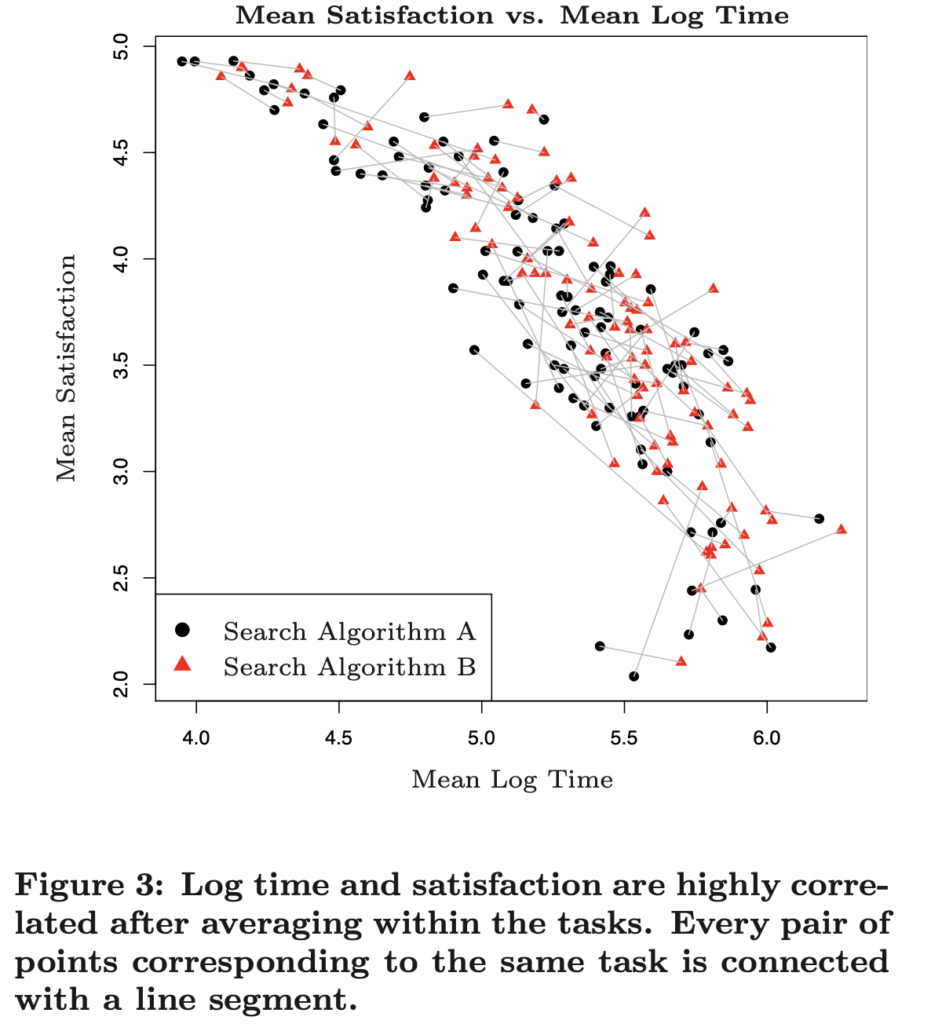

- Comparaison de deux algorithmes de recherche (A vs B) avec des utilisateurs rémunérés.

- 100 tâches réelles issues d’expériences de recherche difficiles vécues par des utilisateurs.

- 200 utilisateurs répartis en deux groupes (chaque groupe teste un algorithme).

- Mesure du temps écoulé entre le début et la fin de la recherche pour chaque tâche.

- Collecte des notes de satisfaction après la recherche.

Résultats principaux

- Une corrélation négative forte (-0,42 à -0,86) entre le temps de recherche et la satisfaction utilisateur :

- Plus le temps de recherche est long, plus l’utilisateur est insatisfait.

- L’algorithme A est plus performant :

- Temps moyen 5,21 (log) vs 5,37 (log) pour B, soit A environ 17% plus rapide que B.

- Pour 75% des tâches, A permet de trouver plus vite l’information.

- Conception expérimentale à améliorer :

- La variabilité entre utilisateurs fausse les résultats.

- Une nouvelle méthode (cross-over design) permettrait de réduire l’erreur de 73% et d’améliorer la fiabilité des conclusions.